spark-Spark-Scala语言实战(11)

推荐 原创在之前的文章中,我们学习了如何在spark中使用RDD中的cartesian,subtract最终两种方法。想了解的朋友可以查看这篇文章。同时,希望我的文章能帮助到你,如果觉得我的文章写的不错,请留下你宝贵的点赞,谢谢。

Spark-Scala语言实战(10)-CSDN博客文章浏览阅读977次,点赞32次,收藏12次。今天开始的文章,我会带给大家如何在spark的中使用我们的RDD方法,今天学习RDD方法中的cartesian,subtract两种方法。希望我的文章能帮助到大家,也欢迎大家来我的文章下交流讨论,共同进步。https://blog.csdn.net/qq_49513817/article/details/137297066?今天的文章开始,我会继续带着大家如何在spark的中使用我们的键值对里的方法。今天学习键值对方法中的join,rightOuterJoin,leftOuterJoin三种方法。

目录

一、知识回顾

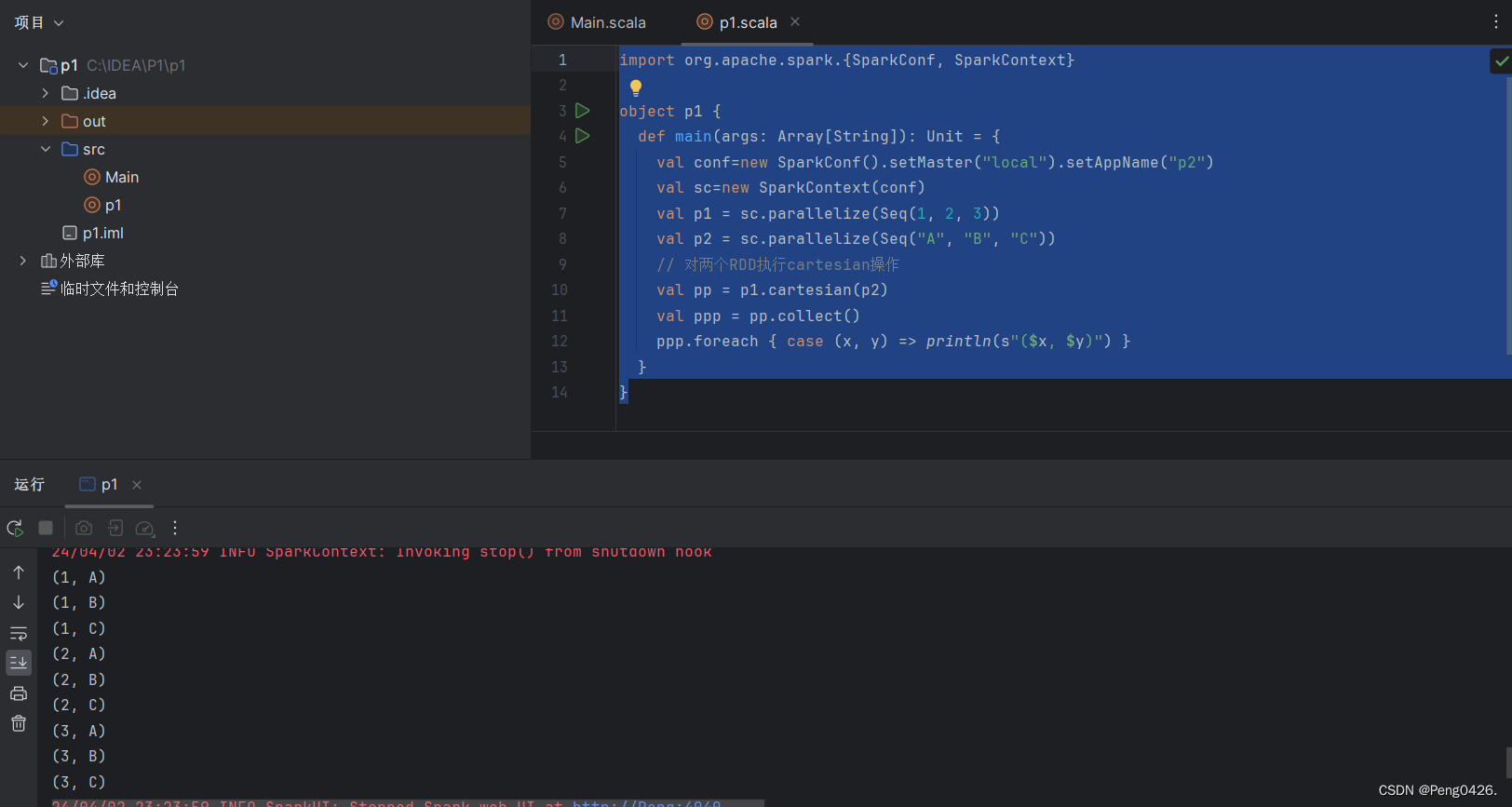

上一篇文章中我们学习了RDD的两种方法,分别是cartesian,subtract。

cartesian可以求笛卡儿积,及两个集合的元素两两组合

可以看到两个集合的元素两两组合在一起了。

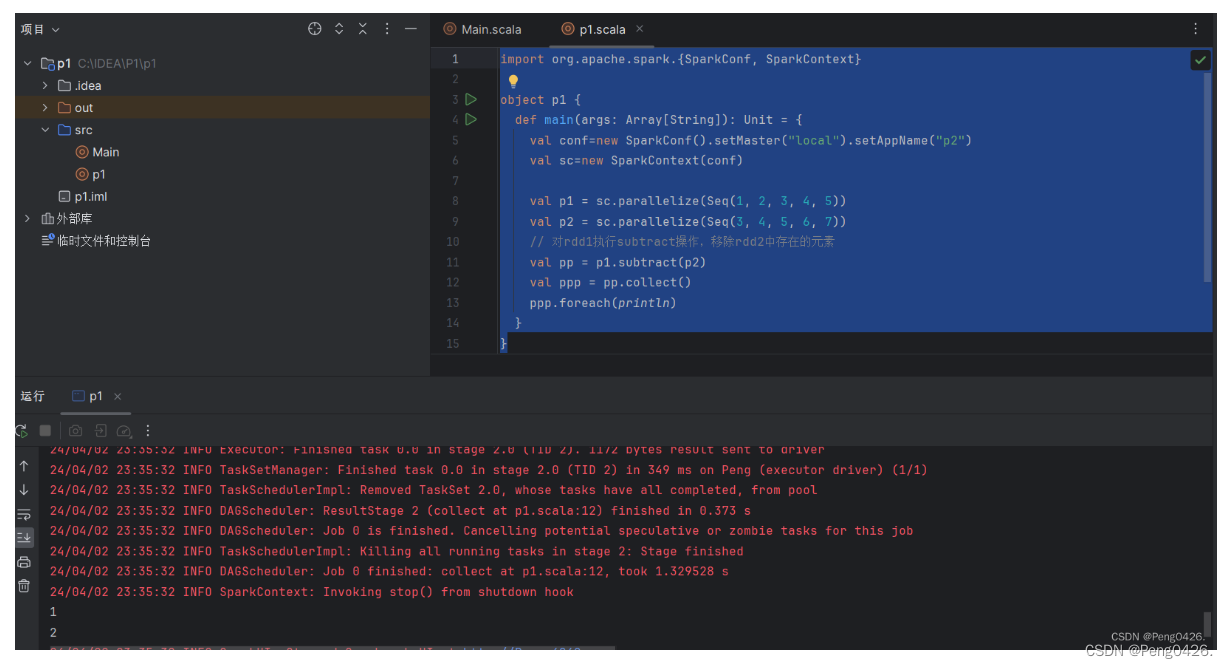

subtract是我们的一个补集操作。

当p2补p1时,肯定会输出p2中没有的p1有的即我们的1,2

当p2补p1时,肯定会输出p2中没有的p1有的即我们的1,2

现在,开始今天的学习吧

二、键值对方法

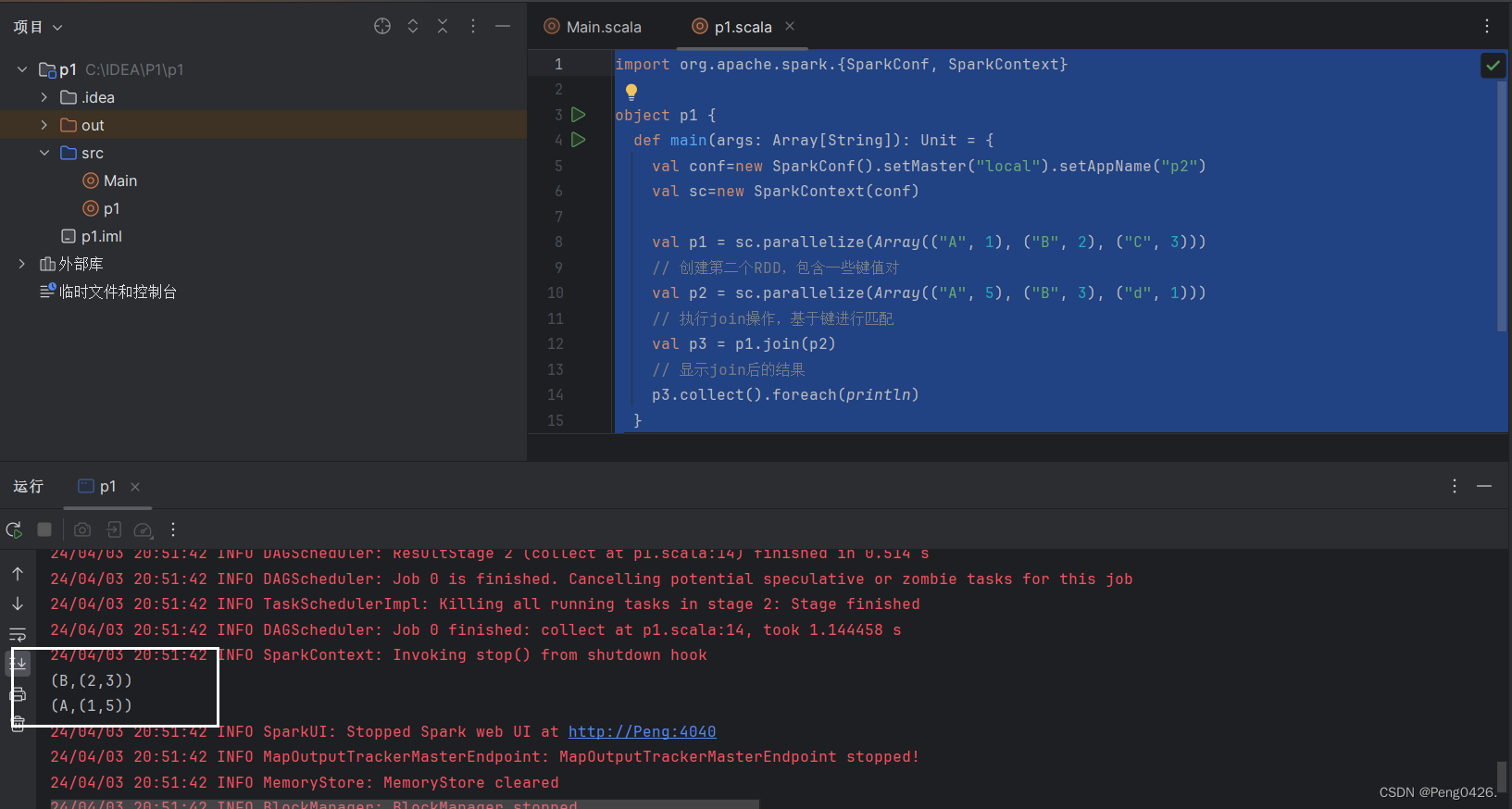

1.join

- join()方法用于根据键对两个RDD进行内连接,将两个RDD中键相同的数据的值存放在一个元组中,最后只返回两个RDD中都存在的键的连接结果。

- 例如,在两个RDD中分别有键值对(K,V)和(K,W),通过join()方法连接会返回(K,(V,W))。

- 创建两个RDD,含有相同键和不同的键,通过join()方法进行内连接。

import org.apache.spark.{SparkConf, SparkContext}

object p1 {

def main(args: Array[String]): Unit = {

val conf=new SparkConf().setMaster("local").setAppName("p2")

val sc=new SparkContext(conf)

// 创建第二个RDD,包含一些键值对

val p1 = sc.parallelize(Array(("A", 1), ("B", 2), ("C", 3)))

// 创建第二个RDD,包含一个不同的键值对

val p2 = sc.parallelize(Array(("A", 5), ("B", 3), ("d", 1)))

// 执行join操作,基于键进行匹配

val p3 = p1.join(p2)

// 显示join后的结果

p3.collect().foreach(println)

}

}可以看到我们的代码创建了两个RDD,包含相同的键A,B与不同的键C,D。那么将它们进行join连接,肯定只会匹配相同键与键的值,那即代表运行我们的代码,看到的只会是我们A,B键与它的值。现在运行代码看看是否与我们所预期的一致吧。

可以看到输出的分别是A,B与它们的值,所预期一致。

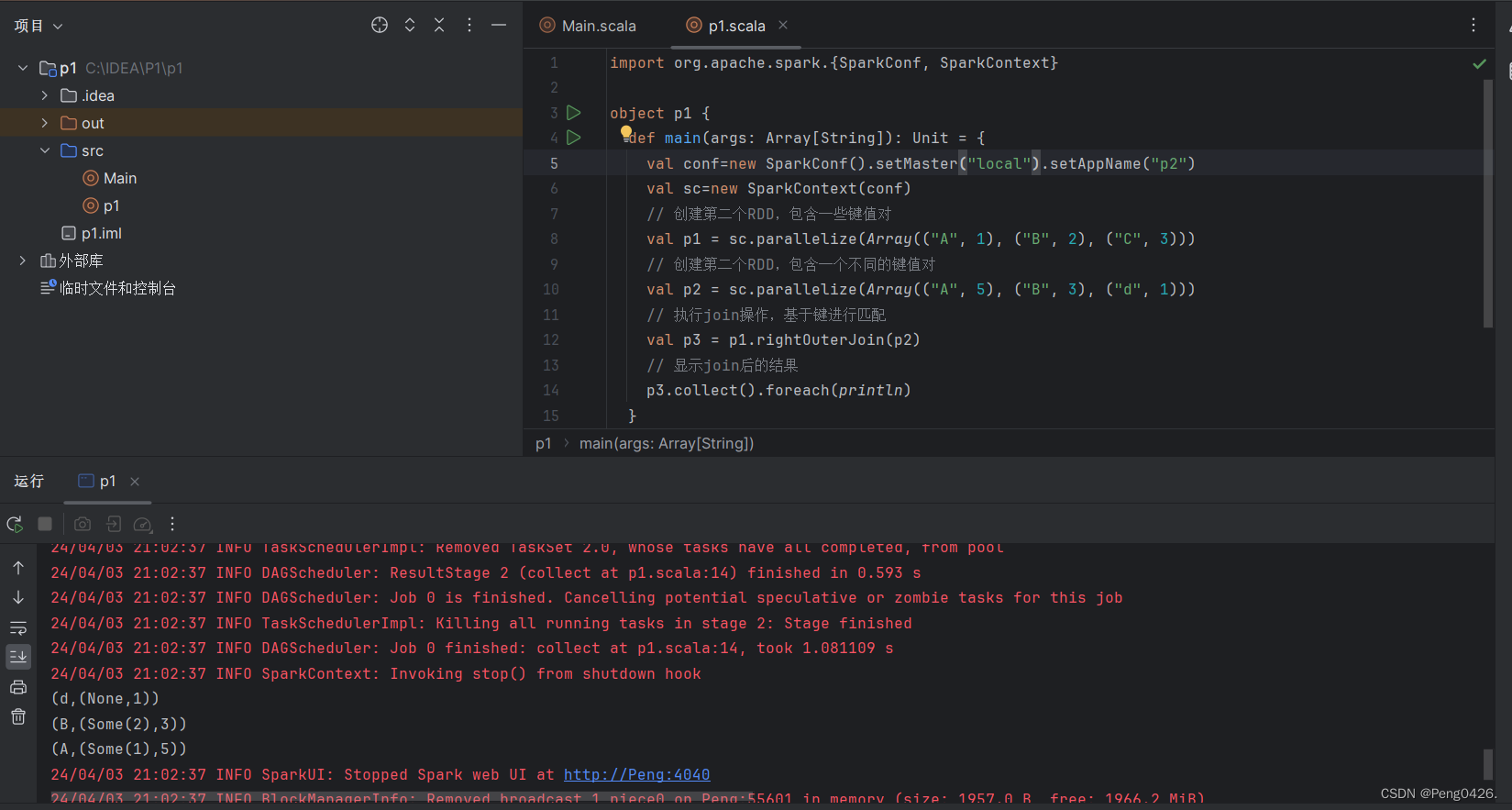

2.rightOuterJoin

- rightOuterJoin()方法用于根据键对两个RDD进行右外连接,连接结果是右边RDD的所有键的连接结果,不管这些键在左边RDD中是否存在。

- 在rightOuterJoin()方法中,如果在左边RDD中有对应的键,那么连接结果中值显示为Some类型值;如果没有,那么显示为None值。

import org.apache.spark.{SparkConf, SparkContext}

object p1 {

def main(args: Array[String]): Unit = {

val conf=new SparkConf().setMaster("local").setAppName("p2")

val sc=new SparkContext(conf)

// 创建第二个RDD,包含一些键值对

val p1 = sc.parallelize(Array(("A", 1), ("B", 2), ("C", 3)))

// 创建第二个RDD,包含一个不同的键值对

val p2 = sc.parallelize(Array(("A", 5), ("B", 3), ("d", 1)))

val p3 = p1.rightOuterJoin(p2)

p3.collect().foreach(println)

}

}通过上面的描述可以知道rightOuterJoin方法在这里使用后,肯定是只会输出p2所包含的,p1有的p2没有就会直接忽略掉,而p2有的p1没有那么相应的输出位置就会为None值,那么在这里,肯定就会是键A,B,d了,且d里肯定有一个空(None)值。

运行代码

可以看到输出与预期一致。

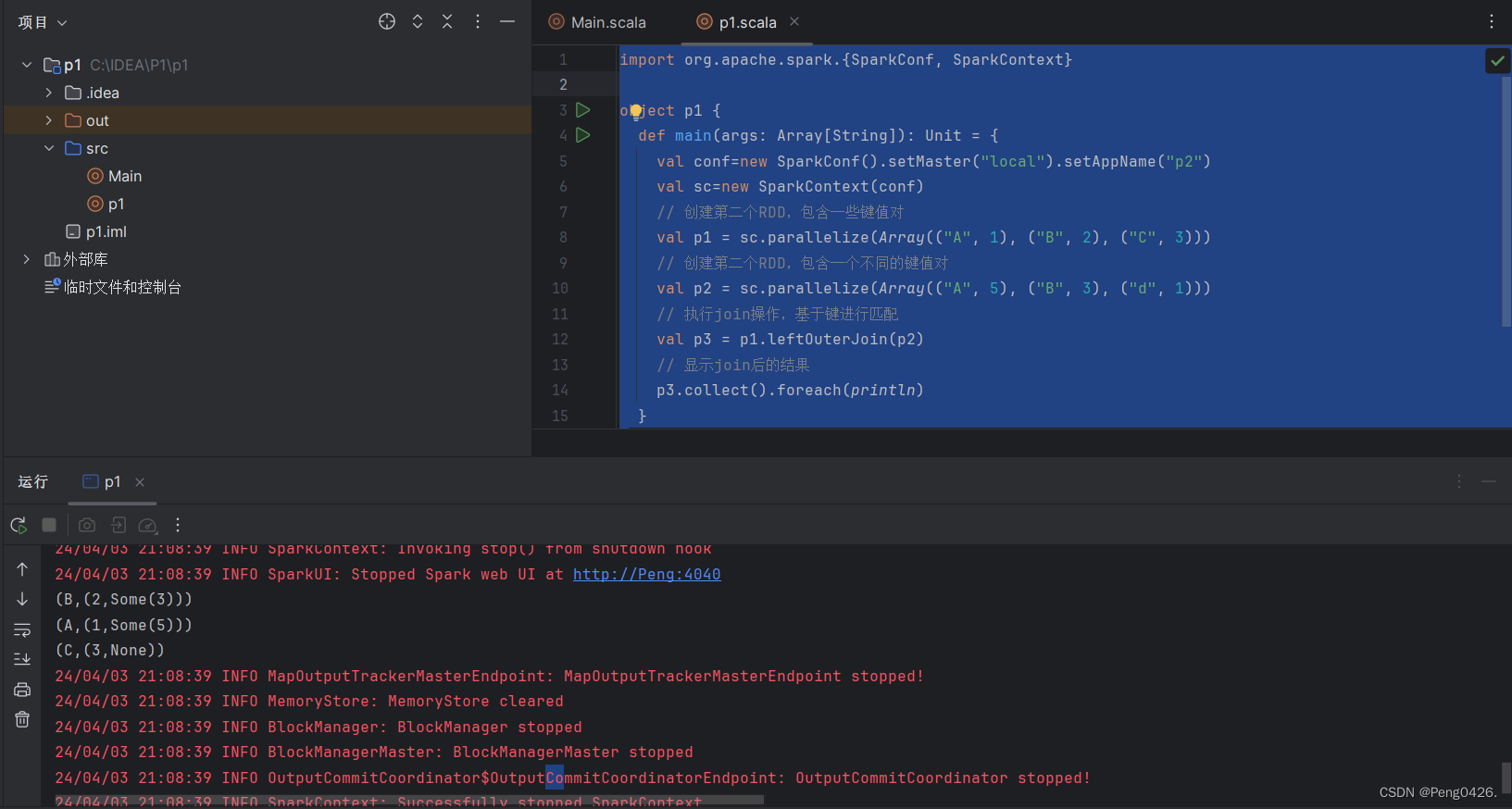

3. leftOuterJoin

- leftOuterJoin()方法用于根据键对两个RDD进行左外连接,与rightOuterJoin()方法相反,返回结果保留左边RDD的所有键。

import org.apache.spark.{SparkConf, SparkContext}

object p1 {

def main(args: Array[String]): Unit = {

val conf=new SparkConf().setMaster("local").setAppName("p2")

val sc=new SparkContext(conf)

// 创建第二个RDD,包含一些键值对

val p1 = sc.parallelize(Array(("A", 1), ("B", 2), ("C", 3)))

// 创建第二个RDD,包含一个不同的键值对

val p2 = sc.parallelize(Array(("A", 5), ("B", 3), ("d", 1)))

// 执行join操作,基于键进行匹配

val p3 = p1.leftOuterJoin(p2)

// 显示join后的结果

p3.collect().foreach(println)

}

}学习了上面,那下面这个 leftOuterJoin就很好理解了,就是与上面相反,肯定是只会输出p1所包含的,p2有的p1没有就会直接忽略掉,同时也会产生空值。

快去试试吧~

拓展-方法参数设置与键值对

1.方法参数设置

| 方法 | 参数 | 参数说明 | 使用例子 | 效果 |

|---|---|---|---|---|

| join | other: RDD[(K, V)] | 另一个需要进行连接的RDD,具有相同的键类型K | rdd1.join(rdd2) | 返回两个RDD的键相同的元素对组成的RDD |

| 仅包含两个RDD中都存在的键对应的元素对 | ||||

| rightOuterJoin | other: RDD[(K, W)] | 另一个需要进行右外连接的RDD,具有相同的键类型K | rdd1.rightOuterJoin(rdd2) | 返回以rdd2的键为基准的左连接结果 |

| rdd1中与rdd2键匹配的元素对会被返回 | ||||

| rdd2中不与rdd1键匹配的键对应的元素对,其值会被设为null | ||||

| leftOuterJoin | other: RDD[(K, W)] | 另一个需要进行左外连接的RDD,具有相同的键类型K | rdd1.leftOuterJoin(rdd2) | 返回以rdd1的键为基准的左连接结果 |

| rdd1中的所有元素对都会被返回 | ||||

| 对于rdd1中与rdd2键匹配的元素对,其值会被正常返回 | ||||

| 对于rdd1中不与rdd2键匹配的键,其值会被设为null |

2.键值对

在 Spark 中,键值对(Key-Value Pair)通常指的是由两个元素组成的元组,其中第一个元素是键(Key),第二个元素是值(Value)。这种键值对的数据结构在 Spark 中非常常见,特别是在处理 RDD(弹性分布式数据集)时。

在 Spark 中,键值对 RDD(Pair RDD)允许你对数据进行一系列的操作,这些操作主要依赖于键。例如,你可以根据键对数据进行分组(groupByKey)、排序(sortByKey)、连接(join)、减少(reduceByKey)等。

键值对 RDD 在 Spark 中通过 scala.Tuple2 类实现,通常简写为 (K, V),其中 K 是键的类型,V 是值的类型。例如,你可以有一个 (String, Int) 类型的键值对 RDD,其中字符串是键,整数是值。

更多【spark-Spark-Scala语言实战(11)】相关视频教程:www.yxfzedu.com

相关文章推荐

- java-【Vue 透传Attributes】 - 其他

- github-在gitlab中指定自定义 CI/CD 配置文件 - 其他

- 编程技术-四、Vue3中使用Pinia解构Store - 其他

- apache-Apache Druid连接回收引发的血案 - 其他

- 编程技术-剑指 Offer 06. 从尾到头打印链表 - 其他

- 编程技术-linux查看端口被哪个进程占用 - 其他

- 编程技术-Linux安装java jdk配置环境 方便查询 - 其他

- hdfs-wpf 命令概述 - 其他

- 编程技术-降水短临预报模型trajGRU简介 - 其他

- jvm-函数模板:C++的神奇之处之一 - 其他

- ddos-ChatGPT 宕机?OpenAI 将中断归咎于 DDoS 攻击 - 其他

- 云原生-云原生周刊:KubeSphere 3.4.1 发布 | 2023.11.13 - 其他

- apache-从零开始Apache2配置php服务并支持网页访问 - 其他

- easyui-【开源三方库】Easyui:基于OpenAtom OpenHarmony ArkUI深度定制的组件框架 - 其他

- 算法-《数据结构、算法与应用C++语言描述》-队列的应用-工厂仿真 - 其他

- 编程技术-蓝桥 1111 第 3 场算法双周赛 深秋的苹果【算法赛】python解析 - 其他

- easyui-ChatRule:基于知识图推理的大语言模型逻辑规则挖掘11.10 - 其他

- hadoop-搭建完全分布式Hadoop - 其他

- 容器-【问题记录】docker pull 镜像的时候 devel 版本和无 devel 版本的差别 - 其他

- spring-spring cloud之服务熔断 - 其他

2):严禁色情、血腥、暴力

3):严禁发布任何形式的广告贴

4):严禁发表关于中国的政治类话题

5):严格遵守中国互联网法律法规

6):有侵权,疑问可发邮件至service@yxfzedu.com

- 软件逆向-RotaJakiro后门与Buni后门关联性分析

- CTF对抗-2022KCTF秋季赛 第三题 水患猖獗

- 二进制漏洞-linux内核pwn之基础rop提权

- Android安全-Base64 编码原理 && 实现

- 软件逆向-对双机调试下KdDebuggerNotPresent标志位的研究

- CTF对抗-KCTF2022秋季赛第二题分析(4qwerty7)

- Pwn-从某新生赛入门PWN(一)

- CTF对抗-KCTF 2022 秋季赛 第二题 wp - 98k战队

- Android安全- 60秒学会用eBPF-BCC hook系统调用 ( 2 ) hook安卓所有syscall

- Pwn-pwn题jarvisoj_fm